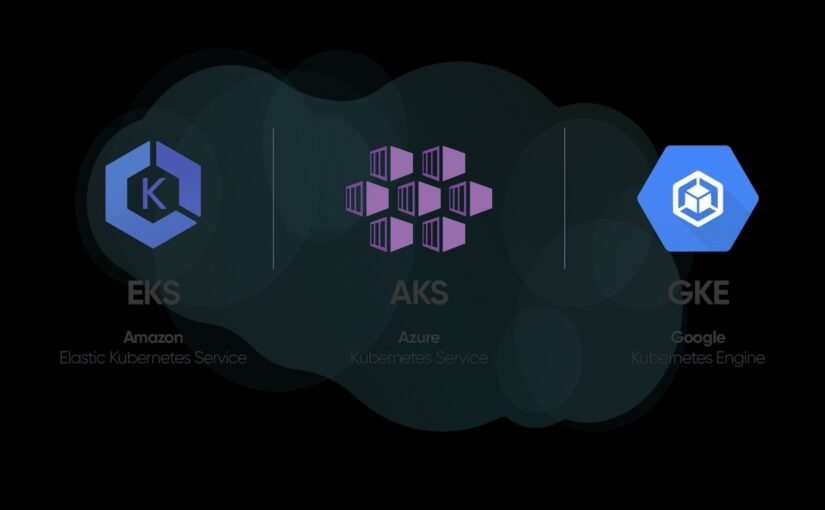

Kubernetes를 도입할 때 가장 많이 하는 착각이 하나 있어요.

“어차피 쿠버네티스면 다 같은 거 아니야?”

EKS AKS GKE 비용에 대한 이야기를 해 보고자 합니다. 쿠버네티스 API는 비슷해도, 운영 난이도와 비용이 갈리는 지점은 ‘관리형이 어디까지 관리해 주느냐’입니다. 그리고 그 차이가 바로 장애 빈도, 운영 인력 투입, 그리고 청구서로 이어집니다. 이번 글에서는 2026년 기준으로 EKS(AWS) vs AKS(Azure) vs GKE(GCP)를 운영 난이도(운영자가 뭘 책임져야 하는지) / 비용(클러스터 관리비 + 숨은 비용) 관점에서 비교해볼게요.

먼저 결론: 어떤 팀에 어떤 선택이 “후회가 덜한가”

✅ 운영을 최대한 “서비스처럼” 쓰고 싶다

- GKE Autopilot: 노드/노드풀을 Google이 항상 만들고 관리(오토 생성/관리)해주는 구조라 운영 난이도를 크게 낮추는 방향입니다.

- AKS Automatic: 노드풀 수동 생성 없이 노드 관리/스케일링/자동 업그레이드/노드 리페어 등을 “기본 탑재”로 가져가는 쪽입니다.

- EKS Auto Mode: 컴퓨트/스토리지/네트워크를 자동화하고 OS 패치·핵심 애드온 관리까지 AWS가 오프로딩하겠다는 방향입니다.

👉 결론적으로 “플랫폼팀이 얇고, 쿠버네티스 전문성이 부족한데도 K8s를 써야 한다”면 Autopilot/Automatic/Auto Mode 계열이 운영 난이도 최저입니다.

✅ 세밀한 통제(노드 타입, 네트워크, 애드온, 비용 최적화)를 직접 하고 싶다

- EKS(표준 모드): 가장 AWS답게 “부품 조립형”이라 자유도가 높습니다. 대신 운영자가 챙길 포인트도 많습니다(장점이자 단점).

- GKE Standard / AKS Standard(일반 노드풀)도 통제가 가능하지만, 각 클라우드의 “권장 레일”을 벗어날수록 운영 난이도가 올라갑니다.

1) 운영 난이도 비교: 실무에서 힘든 6가지 포인트로 보자

아래 6개가 실제 운영 난이도를 결정합니다.

- 클러스터 생성/기본 구성

- 노드/노드풀 운영(프로비저닝, 스케일링, OS 패치, 업그레이드)

- 업그레이드/버전 지원 정책

- 권한·인증(IAM/ID 연동)

- 네트워킹/인그레스/로드밸런서

- 관측성(로그/메트릭/트레이싱) + 운영 표준화

2) 노드 운영 책임: “가장 많이 터지는” 차이

EKS: 관리형 노드 그룹이어도 “노드 업그레이드/전개는 내 책임”

AWS 문서에서 EKS Optimized AMI는 AWS가 최신 패치 버전을 만들지만, Managed Node Group 사용 고객은 최신 AMI로 노드그룹 업그레이드를 수행해야 한다고 명시합니다.

- 장점: 내가 원하는 타이밍/전략(블루그린/카나리/서지)으로 통제 가능

- 단점: “컨트롤 플레인 올렸는데 워커노드 안 올려서” 호환성 이슈/보안 공백이 생기기 쉬움

✅ 운영 난이도 줄이고 싶으면: EKS Auto Mode로 오프로딩 범위를 넓히는 선택지가 있습니다. (단, 비용 구조는 아래에서 같이 봅니다.)

GKE Autopilot: 업그레이드·유지보수까지 Google이 자동 관리

GKE Autopilot 개요 문서에 Autopilot은 컨트롤 플레인과 워커 노드 모두의 업그레이드 및 유지보수를 자동으로 관리한다고 안내합니다.

- 장점: 운영 인력 투입이 확 줄어듦(특히 패치/업그레이드 영역)

- 단점: “내가 노드를 마음대로 만지는” 영역은 제한될 수 있음(완전 통제보다는 관리형 철학)

AKS Automatic: 노드풀 수동 운영 부담을 줄이는 “기본 탑재형”

AKS Automatic 소개 문서에 노드 관리가 자동이며, 수동 노드풀 생성 없이 스케일링/자동 노드 리페어/자동 업그레이드 등이 구성된다고 설명합니다.

또한 Azure의 AKS 가격 페이지는 Automatic은 노드를 관리해 주고, Standard는 사용자가 노드풀을 만들고 관리한다는 비교를 보여줍니다.

3) 인증/권한(IAM) 난이도: 팀 문화에 따라 체감이 갈린다

EKS: “AWS IAM ↔ Kubernetes RBAC” 매핑이 핵심

EKS는 aws-auth ConfigMap이 AWS IAM 사용자/역할을 Kubernetes RBAC 권한으로 매핑한다고 명시합니다.

- AWS IAM 중심 조직(보안/감사 체계가 IAM 기준인 팀)에게는 강점

- 반대로 “쿠버네티스 RBAC만 알던 팀”은 초기에 낯설 수 있음

AKS: Microsoft Entra ID(구 AAD) + Kubernetes RBAC

AKS 문서에서 Microsoft Entra 통합 + Kubernetes RBAC 흐름을 안내하고, 생성 시 RBAC가 기본 활성화된다고 설명합니다.

- MS 생태계(Entra, M365, AD/그룹 기반 권한 관리)가 강한 조직이면 운영 난이도가 확 내려감

GKE: Workload Identity Federation이 “권장(Recommended)”

Google 문서에서 Workload Identity Federation for GKE가 대부분의 경우 권장되는 방식이라고 명확히 말합니다.

- 장점: 워크로드가 Google Cloud API에 접근할 때 “키 파일/시크릿 관리” 부담을 줄이는 방향(보안·운영 측면에서 유리)

4) 운영 난이도 총평(체감 순위)

운영 난이도는 “어떤 모드로 쓰느냐”까지 포함해서 보는 게 현실적입니다.

| 운영 부담이 낮은 쪽 ← | 추천 조합(대표) | → 운영 통제가 강한 쪽 |

|---|---|---|

| GKE Autopilot | (Google이 노드/업그레이드 관리) | GKE Standard |

| AKS Automatic | (기본 운영 자동화 탑재) | AKS Standard |

| EKS Auto Mode | (AWS가 더 많이 오프로딩) | EKS 표준(Managed Node Group/Karpenter 등) |

5) 비용 비교: “클러스터 관리비 + 데이터 플레인 + 숨은 비용”으로 나눠라

쿠버네티스 비용을 한 줄로 요약하면 이렇게 됩니다.

총비용 = (클러스터 관리비) + (노드/파드 컴퓨트) + (LB/스토리지/로그/네트워크) + (버전 지원/옵션 과금)

여기서 많은 팀이 클러스터 관리비(컨트롤 플레인 비용)를 놓치거나,

반대로 관리비만 보고 “싸다/비싸다”를 결론냅니다.

실제는 노드/네트워크/로그가 더 크게 나오는 케이스가 많아요.

6) 클러스터 관리비(컨트롤 플레인 비용) 2026년 기준

✅ EKS

- 표준 지원 Kubernetes 버전: $0.10 / 클러스터·시간

- 확장 지원(Extended support): $0.60 / 클러스터·시간 (표준 $0.10 + 추가 $0.50)

또한 EKS는 “Provisioned Control Plane(더 큰 티어)”를 선택하면 $1.65/hr(또는 그 이상) 같은 별도 과금이 추가됩니다.

✅ GKE

- 클러스터 관리비: $0.10 / 클러스터·시간 (모드/토폴로지와 무관)

- 무료 티어 크레딧: 월 $74.40 (대략 “zonal Standard 1개 또는 Autopilot 1개” 수준)

- 확장(extended support) 기간 추가 관리비: 추가 $0.50/hr → 총 $0.60/hr

✅ AKS

AKS는 Free(무 SLA), Standard(SLA), Premium(SLA+LTS) 형태로 “클러스터 관리 티어”가 나뉩니다.

Azure 가격 페이지 검색 스니펫 기준으로는(표시 단위 Month):

- Free: 관리비 Free(리소스만 과금)

- Standard(SLA): $73 / 클러스터·월

- Premium(SLA+LTS): $438 / 클러스터·월

참고: $73/월, $438/월은 “월 730시간 기준”으로 환산하면 각각 대략 $0.10/hr, $0.60/hr 수준입니다(단순 계산).

또한 Microsoft 문서에서 Standard/Premium은 Uptime SLA가 기본 포함이며, AZ 사용 시 99.95%, 미사용 시 99.9%를 안내합니다.

7) “관리비만” 놓고 보면 현실은 이렇다

- EKS 표준 vs GKE 표준: 둘 다 $0.10/hr(대략 월 $72~$74)로 비슷합니다.

- AKS Free tier: 관리비가 0이라 개발/학습에는 유리하지만, Azure도 Free tier는 대규모/고가용성 용도가 아니다라고 FAQ에서 분명히 선을 긋습니다(>10 노드 규모/HA 요구 비권장).

- 버전 업그레이드 미루면 “확장 지원비” 폭탄: EKS는 Extended support가 $0.60/hr로 뛴다고 명시되어 있습니다. GKE도 extended support 기간 추가 관리비로 총 $0.60/hr가 됩니다.

8) 데이터 플레인(노드/파드) 과금: “어떻게 청구되느냐”가 다르다

EKS

- 기본은 EC2 인스턴스 비용(노드) + EKS 관리비

- EKS Auto Mode는 Auto Mode가 런칭/관리한 EC2의 “추가 과금(EC2 비용 외 별도)”이 붙고, 초 단위(1분 최소) 청구라고 안내합니다.

즉, “운영을 덜어주는 만큼” 비용 구조가 추가로 생길 수 있습니다.

GKE

- Standard 노드풀: 노드의 Compute Engine 인스턴스 비용을 그대로 냅니다.

- Autopilot(파드 기반): 실행 중인 파드가 요청(request)한 CPU/메모리/임시 스토리지 기준으로 과금되는 Pod-based billing을 설명합니다.

운영자 관점에서 중요한 포인트는 이거예요.

Autopilot은 “노드 빈 공간”을 줄일 수 있지만,

리소스 request를 크게 잡으면 그대로 과금이 커진다.

AKS

- 기본적으로는 VM(노드) 비용 + 네트워크/스토리지 + (선택한 티어의 관리비) 구조입니다.

- AKS Automatic은 노드 운영을 더 오프로딩하지만, 비용 자체는 결국 노드/리소스 사용량에 크게 좌우됩니다.

9) 숨은 비용 Top 6: “K8s는 공짜인데 청구서가 왜 이래?”의 정체

클라우드 K8s 비용이 튀는 흔한 원인은 보통 여기서 나옵니다.

- 로드밸런서(LB) 남발: 서비스마다 LB 붙이면 비용이 기하급수

- NAT/이그레스(외부 트래픽) 비용: 크롤러/이미지/다운로드 트래픽이 크면 바로 티가 남

- 로그 폭탄: 컨테이너 stdout을 무한정 쌓으면 로그 비용이 월 비용 1등이 되기도 함

- 스토리지(PV) 방치: 볼륨/스냅샷/백업 정책 미정리

- 클러스터를 환경별로 너무 많이 만들기: “dev/stage/prod + 팀별”로 늘어나면 관리비와 운영비가 같이 늘어남

- 버전 업그레이드 지연 → 확장 지원비(특히 EKS/GKE)

10) 비용 예시로 감 잡기: “클러스터 1개를 24/7로 돌리면?”

컨트롤 플레인/관리비만 단순 계산해보면:

- $0.10/hr × 744시간(31일) = $74.40/월

- $0.60/hr × 744시간(31일) = $446.40/월

이게 왜 중요하냐면,

“클러스터 수를 줄이는 것”과

“버전 업그레이드를 제때 하는 것”이

운영 노력 대비 비용 절감 효과가 엄청 큰 레버이기 때문입니다.

EKS는 표준 $0.10/hr, 확장 $0.60/hr를 명시합니다.

GKE도 $0.10/hr 관리비, 확장 기간 추가로 총 $0.60/hr 구조를 안내합니다.

AKS는 월 표시 기준 Standard $73/월, Premium $438/월로 안내됩니다.

11) 그래서 무엇을 선택해야 하나: 체크리스트로 결정하자

아래 10개 중 “YES”가 많은 쪽이 정답일 확률이 높습니다.

EKS가 유리한 경우

- 이미 AWS에 데이터/보안/네트워크가 깊게 묶여 있다

- IAM 중심으로 권한/감사 체계를 운영한다

- 노드 타입(Graviton/Spot/특수 인스턴스)까지 세밀하게 최적화하고 싶다

- 쿠버네티스 운영 경험자(플랫폼팀)가 있다

- 필요하면 Auto Mode로 운영 부담을 낮추는 선택지도 고려 가능

AKS가 유리한 경우

- 조직이 Microsoft Entra(AD), Windows, .NET, MS 생태계 중심이다

- 운영은 단순하게 가고 싶고(Automatic), 그래도 Azure 네이티브로 가고 싶다

- Free/Standard/Premium 티어로 SLA·지원 기간을 계약적으로 정리하고 싶다

GKE가 유리한 경우

- 쿠버네티스를 가장 “쿠버네티스답게” 굴리고 싶다(표준/문서/운영 도구 성숙도)

- Autopilot로 노드 관리·업그레이드 부담을 크게 줄이고 싶다

- Google Cloud API 접근을 Workload Identity로 깔끔하게 운영하고 싶다

- 관리비 구조가 명확하고(클러스터당 $0.10/hr), 무료 티어로 1개 클러스터는 상쇄하고 싶다

12) 운영 난이도 & 비용, 한 줄 요약

- 운영 난이도 최저(관리형 극대화): GKE Autopilot / AKS Automatic / EKS Auto Mode

- 운영 통제 최강(부품 조립형): EKS 표준(Managed node group 중심) — 대신 노드 업그레이드 같은 책임이 남음

- 관리비만 보면: EKS와 GKE는 $0.10/hr로 비슷, AKS는 티어에 따라 Free/유료로 갈림

- 진짜 비용은: 노드/네트워크/로그/버전 지원(확장 지원비)에서 크게 갈린다

FAQ (구글 SEO용)

Q1. EKS/AKS/GKE 중 “무조건 제일 싼” 건 뭔가요?

“클러스터 관리비”만 보면 EKS/GKE는 $0.10/hr 수준으로 비슷하고 , AKS는 Free/Standard/Premium 티어 선택에 따라 달라집니다.

하지만 실제 총비용은 노드/네트워크/로그가 더 큰 비중을 차지하는 경우가 많아서, 워크로드 패턴(트래픽·CPU·메모리·이그레스) 기반으로 비교하는 게 맞습니다.

Q2. GKE Autopilot은 왜 운영이 쉬운가요?

Google 문서에서 Autopilot은 컨트롤 플레인과 워커 노드의 업그레이드/유지보수를 자동 관리한다고 안내합니다.

또한 Autopilot 모드에서는 노드와 노드풀을 GKE가 생성/관리합니다.

Q3. AKS Free tier로 운영(프로덕션)해도 되나요?

Azure는 Free tier가 “실험/개발”에 적합하며, 규모(>10 노드)나 고가용성을 요구하는 용도가 아니라고 FAQ에서 설명합니다.

프로덕션이라면 보통 Standard(SLA) 이상을 고려하는 게 안전합니다.

Q4. EKS에서 왜 노드 업그레이드가 자주 문제가 되나요?

AWS는 패치된 AMI를 제공할 수 있지만, Managed Node Group 고객이 노드그룹을 최신 AMI로 업그레이드하는 책임이 있다고 안내합니다.

컨트롤 플레인만 올리고 노드를 방치하면 호환성/보안 이슈가 생길 수 있어요.

Q5. 세 클라우드 모두 “버전 지원비 폭탄”이 있나요?

- EKS는 Kubernetes 버전이 표준 지원을 벗어나면 Extended support로 $0.60/hr가 된다고 명시합니다.

- GKE도 extended support 기간에 추가 관리비가 붙어 총 $0.60/hr가 될 수 있습니다.

- AKS는 Premium에서 LTS(장기 지원)를 제공하는 구조가 있습니다.

원하시면, (1) 월 트래픽/피크, (2) 평균 파드 수·리소스 request, (3) 멀티 AZ/멀티 리전 여부만 기준으로

EKS/AKS/GKE 각각에서 월 비용이 어디서 터질지(로그/LB/NAT/관리비/노드)를 “예산 시뮬레이션 형태”로 더 구체적으로 잡아드릴게요.

| AX 100배의 법칙 – 나와 조직의 능력을 100배 높이는 AI 경영의 실제 도서 구매 |

함께 읽으면 좋은 글:

디지털 트랜스포메이션: 조직의 습관을 바꾸는 일, 도서 구매