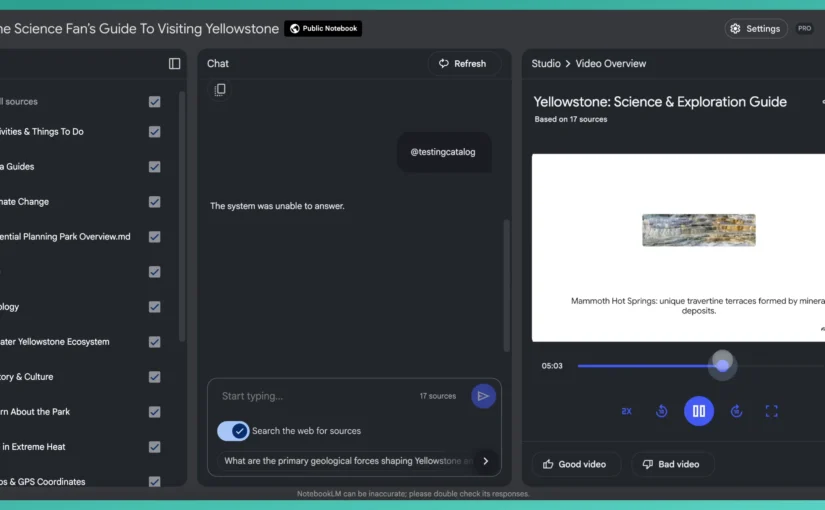

구글이 자사의 AI 기반 학습 및 노트 작성 도구인 NotebookLM에 ‘비디오 개요(Video Overviews)’ 기능을 추가했습니다. 기존 오디오 기반 요약 기능(Audio Overviews)만으로도 사용자들은 콘텐츠의 핵심을 빠르게 파악할 수 있었지만, 이번 비디오 기능 도입을 통해 시각적인 정보 전달까지 지원함으로써 AI 활용의 새로운 가능성을 열었습니다. 개인적으로도 잘 사용하던 NotebookLM 비디오 기능은 콘텐츠 활용의 한 단계가 또 점프하는 느낌을 주는 것 같습니다.

NotebookLM이란 무엇인가?

NotebookLM은 사용자가 업로드한 문서, PDF, 이미지 등 다양한 형식의 자료를 기반으로 자동 요약, 정보 정리, 콘텐츠 재구성이 가능한 구글의 AI 서비스입니다. 처음에는 단순 텍스트 요약 중심이었지만, 이후 오디오 개요 기능이 추가되면서 학습자가 주요 내용을 음성으로 들을 수 있도록 지원했고, 이번에는 그 시각적 확장판인 비디오 개요까지 제공하게 됐습니다.

기존의 자료 이해 방식을 넘어서, 읽고 들을 뿐 아니라 ‘보며’ 학습하는 통합형 플랫폼으로 진화하고 있습니다.

NotebookLM 비디오 개요(Video Overviews)란?

NotebookLM 비디오 개요는 단순히 AI가 동영상을 만들어주는 기능을 넘어섭니다. 구글은 이 기능을 ‘시각 정보를 활용한 이해도 향상 AI 영상 콘텐츠’라고 설명합니다.

예를 들면 경제 보고서나 학술 논문처럼 이해하기 어려운 문서를 업로드하면, AI가 중요한 인용문, 수치, 다이어그램 등을 시각화해 영상 콘텐츠로 재구성합니다. 이 영상은 복잡한 개념을 보다 쉽게 전달하며, 학습자는 단시간에 문서의 핵심을 파악할 수 있습니다. 다음의 소개 영상을 참고해 보세요.

오디오 개요와의 차이점

오디오 개요는 AI가 텍스트 내용을 팟캐스트처럼 요약해 들려주는 기능으로, 특히 이동 중 학습이나 멀티태스킹이 필요한 사용자들 사이에서 인기가 높았습니다. 반면 비디오 개요는 시청각 정보를 동시에 제공합니다.

즉, 오디오는 ‘귀로 듣는 요약’, 비디오는 ‘눈으로 보는 설명’입니다. 영상 내에는 색상, 그래프, 텍스트 애니메이션 같은 시각 요소들이 포함돼 데이터나 개념을 더 직관적으로 이해할 수 있도록 돕습니다. 두 기능은 사용자의 상황에 따라 병행 사용이 가능합니다.

개인화된 구성: 사용자가 원하는 방식대로

NotebookLM의 강점은 사용자의 요청에 따라 콘텐츠를 ‘맞춤’형으로 재구성할 수 있다는 점입니다. 비디오 개요 기능 역시 다음과 같은 요청이 가능합니다.

예를 들어, “이 문서에서 시장 예측과 관련된 부분만 중심으로 설명해줘”라고 지시할 수 있습니다. 혹은 “처음 이 주제를 접하는 고등학생이 이해할 수 있도록 쉽게 설명해줘” 같은 요청도 가능합니다.

이처럼 학습 목적, 대상 청중, 초점을 맞추고 싶은 주제를 지정하면 AI가 이에 맞는 콘텐츠를 생성해 줍니다. 단순 요약을 넘어서, 마치 프레젠테이션 전문가가 만든 영상 자료처럼 활용할 수 있습니다.

예시 사례: 대학생 논문 요약부터 기업 보고서 정리까지

다음의 가상의 사례로 어떤 변화가 있을 수 있는지 살펴보겠습니다.

홍익대학교 산업디자인과 3학년 김다예 씨는 ‘UX 디자인과 인지 부하 저감’이라는 주제의 논문을 졸업 과제로 작성했습니다. 이 논문을 NotebookLM에 업로드한 뒤, 핵심 이론과 다이어그램 중심으로 구성된 비디오 개요를 생성했습니다. 이 비디오는 발표 자료로도 훌륭하게 활용됐고, 설명의 정확성과 전달력 면에서 교수진의 긍정적인 평가를 받았습니다.

또한 모그룹의 한 마케팅 실무자는 매주 10페이지에 달하는 시장 조사 보고서를 내부 팀과 공유해야 했습니다. 이때 그가 사용한 방식은 단순했습니다. 보고서를 NotebookLM에 올리고, 주요 지표와 인사이트를 중심으로 짧은 비디오 형식의 요약을 만든 다음, 이를 이메일로 공유한 것입니다. 이 영상은 복잡한 자료를 보다 빠르게 이해할 수 있게 만들었고, 회의 시간도 줄이는 데 효과적이었다고 합니다.

NotebookLM Studio의 주요 업데이트

구글은 이번 비디오 개요 도입과 함께 NotebookLM Studio에 다음과 같은 기능들을 더했습니다.

이제 하나의 문서에서 오디오, 비디오, 마인드맵, 보고서를 동시에 생성하고 저장할 수 있게 되었습니다. 또한 사용자 인터페이스 상단에 원하는 방식의 콘텐츠 생성 버튼이 배치돼, 클릭 한 번으로 다양한 형태의 정보 출력을 관리할 수 있습니다.

특히 오디오 개요를 재생하면서 다른 탭에서는 마인드맵을 동시에 확인하는 방식도 가능해졌습니다. 이는 전통적인 콘텐츠 관리와는 다른, AI 중심의 멀티태스킹 학습 환경을 의미합니다.

이제는 영상 콘텐츠의 시대: 왜 비디오 개요가 필요한가

2025년을 기준으로 Z세대 이하의 인터넷 사용자의 74%가 텍스트보다 비디오 콘텐츠를 더 선호하는 것으로 나타났습니다. 유튜브로 강의를 듣고, 인스타그램에서 뉴스를 접하며, 틱톡으로 경제 공부를 하는 세대에겐 영상 기반 정보 전달이 자연스러운 선택지입니다.

NotebookLM Video Overviews는 이러한 콘텐츠 소비 트렌드를 학습 환경으로 끌어왔다는 점에서 의미가 큽니다. 단지 AI가 글을 이해하고 요약하는 것에서 나아가, 시각적 언어로 재가공하고 전달하는 수준까지 진화한 것입니다.

실용적 활용 예시: 교육, 기업, 개인 창작 도구로의 확장

비디오 개요 기능은 학습이나 보고서 정리를 넘어서 전방위적으로 활용될 수 있습니다.

학원을 운영하는 교육자는 교재 내용을 쉽게 시각화해 수업에 활용할 수 있습니다. 기업 인사팀은 직원들에게 복리후생, 사내 규정 등을 이해하기 쉬운 영상으로 안내할 수 있습니다. 프리랜서 디자이너는 클라이언트가 이해하기 어려워하던 개념을 직관적으로 설명할 수 있고, 유튜버나 콘텐츠 크리에이터는 배경 자료를 시각적으로 구성해 활용도 높은 콘텐츠를 제작할 수 있습니다.

향후 확장 가능성: 다국어 지원과 협업 툴로의 진화

현재 비디오 개요는 영어 사용자를 대상으로 제공되고 있으나, 구글은 한국어와 스페인어, 프랑스어 등 다양한 언어 지원을 준비 중입니다. 이 기능이 다국어로 확대되면 전 세계 교육자, 기업, 공공 기관들이 공동 작업 툴로 활용할 가능성이 커집니다.

또한, 생성된 비디오를 구글 드라이브, 유튜브, 클래스룸 등에 연동해 실시간으로 배포할 수 있다면, 온라인 학습이나 내부 커뮤니케이션 방식도 크게 달라질 것입니다.

SEO 관점에서 본 시각 요약의 가치

Search Engine Optimization(SEO) 관점에서도 NotebookLM의 비디오 개요는 주목할 만한 의미를 가집니다. 텍스트 중심 콘텐츠의 경우, 사용자가 모든 내용을 읽으려면 시간이 걸리고, 이 과정에서 이탈률이 높아질 수 있습니다.

반면, 시각적으로 요약된 영상은 클릭 후 몇 초 안에 메시지를 전달할 수 있어, Dwell Time(머문 시간)과 Engagement(관여도)를 높이기 쉽습니다. 이는 검색 결과 상단에 노출되는 ‘지식 패널’, ‘추천 스니펫’ 영역에서 더 많은 주목을 받을 수 있는 콘텐츠를 만들 수 있다는 뜻이기도 합니다.

결론: NotebookLM 비디오 개요는 ‘설명하는 AI’ 시대의 시작

정리하자면 NotebookLM의 비디오 개요 기능은 단순한 기능 추가 이상의 의미를 가질 수 있습니다. 정보의 핵심을 이해하고 전달하는 AI가, 이제는 읽는 것에서 그치지 않고 ‘보여주고 설명하는’ 단계로 넘어왔습니다.

이제 NotebookLM은 단순한 노트 정리 툴이 아닌, 학습 자료 제작 도구이자 프레젠테이션 파트너, 내부 커뮤니케이션 툴로서의 역할까지 수행하고 있습니다. 학업, 마케팅, 교육, 브랜딩 등 다양한 분야에서 이 기능이 어떤 가치를 만들어낼 수 있을지는 사용자에 달려 있습니다. 앞으로 일하는 방식, 배우는 방식 자체에 변화를 불러올 기술로서, 계속 주목할 필요가 있습니다. 구글의 동시 다발적인 일상 업무로의 침투가 개인적으로 마이크로소프트의 속도보다 빠르고, 좋은 품질로 느껴지는 요즘입니다. 어떻게 상황이 또 전개될지 관심을 가지고 지켜보시죠.

| AX 100배의 법칙 – 나와 조직의 능력을 100배 높이는 AI 경영의 실제 도서 구매 |

함께 읽으면 좋은 글:

디지털 트랜스포메이션: 조직의 습관을 바꾸는 일, 도서 구매